★ When CloudOS receives notification of excessively high container CPU/memory usage, how should it be handled?

- 0 Followed

- 0Collected ,4897Browsed

Network Topology

null

Problem Description

CloudOS receives notification of excessively high container CPU/memory usage. It could potentially affect the running of the container, and subsequently impact the business.

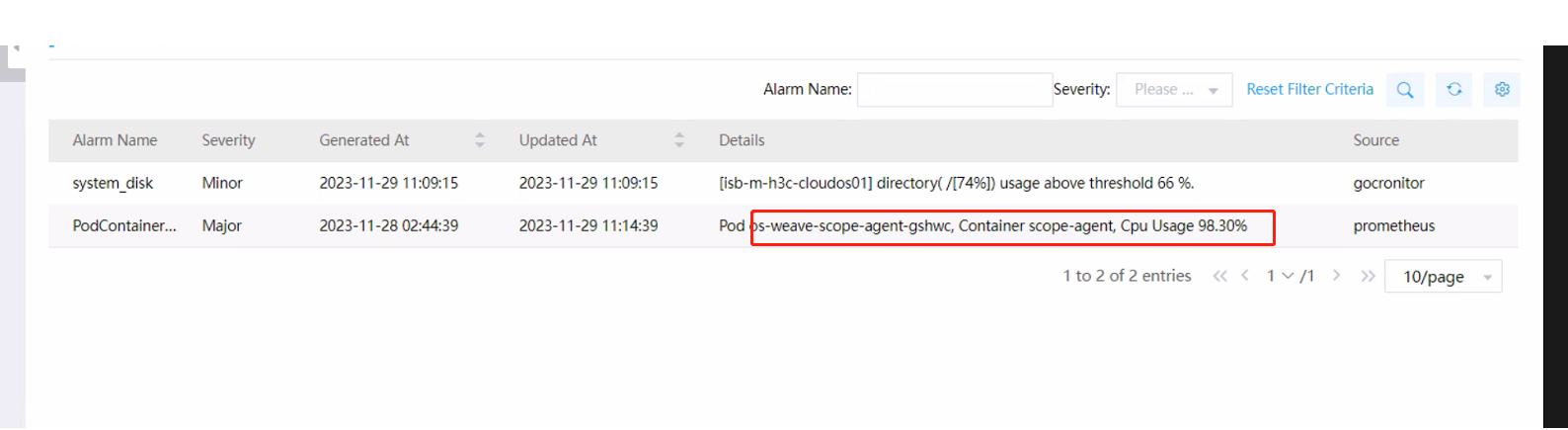

As show in picture, we received the alarm from pod os-weave-scope-agent.

Process Analysis

The memory resources occupied by this container are related to the actual business load on the site. The larger the scale of the business, the higher the resource utilization. At times, initial memory allocation may not be sufficient, triggering foreground alarms. As the controller container has a leader, responsible for handling requests, only one instance may exhibit high memory usage. Therefore, in such cases, increasing the memory limit for the controller container should suffice.

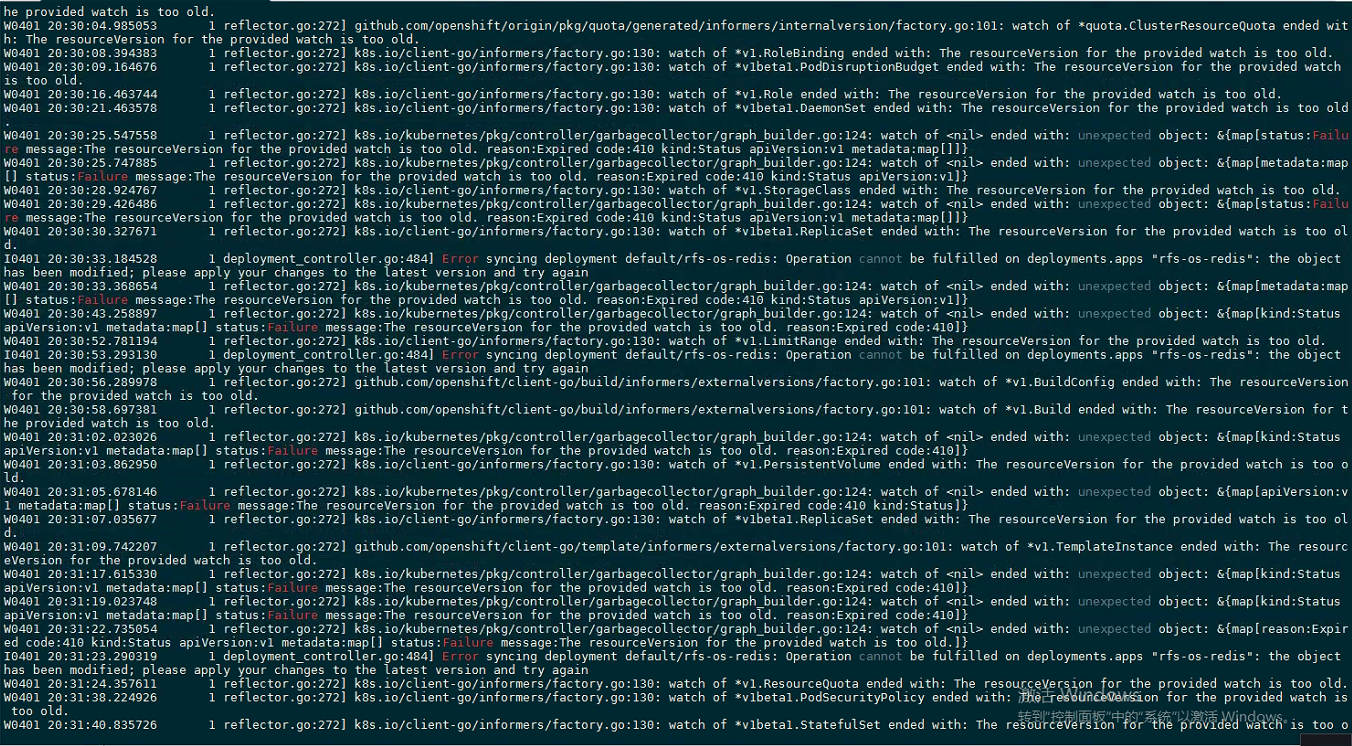

(P.S. When using the "kubectl logs xxxx" command, you may see error prints such as the following. These prints are non-exceptional and can be disregarded.)

Solution

You can increase the memory allocation value for the master-controllers-xxx container based on its actual memory usage, using the following method:

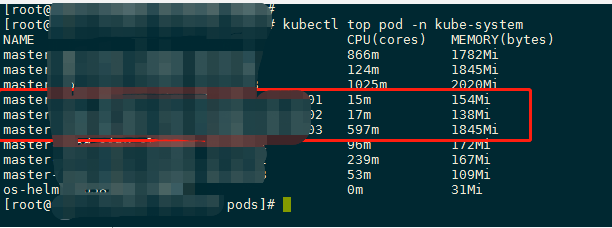

1. Enter "kubectl top pod -n kube-system" to observe the actual memory usage of the container.

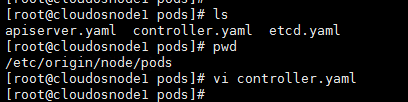

2. Modify the /etc/origin/node/pods/controller.yaml file on the CloudOS control node accordingly.

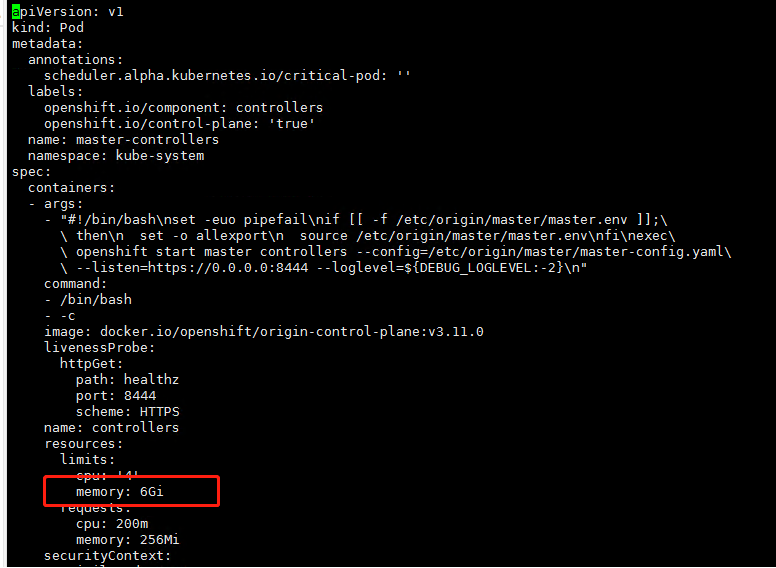

Increase the limitation value, and the target value can be determined based on the usage from step 1. (The following screenshot is for illustration purposes only, and does not represent the recommended modification values.)

3. After saving, the pod will automatically restart. Once the pod is running again, proceed to modify the next node. After completing all modifications, the alerts should disappear.